(Auszug aus der Pressemitteilung)

Supermicro, Inc. (NASDAQ: SMCI), ein Anbieter von IT-Gesamtlösungen für KI, Cloud, Storage und 5G/Edge, hat sein leistungsstärkstes KI SuperCluster System vorgestellt: eine Rack-Scale-Lösung basierend auf der NVIDIA Blackwell-Plattform, die KI-Workloads im Billionen-Parameter-Bereich ermöglicht. Die neuen SuperCluster Lösungen erhöhen die Anzahl der möglichen NVIDIA HGX B200 8-GPU-Systeme in einem flüssigkeitsgekühlten Rack deutlich, was zu einer starken Erhöhung der GPU-Rechenleistung im Vergleich zu Supermicros aktuellen branchenführenden flüssigkeitsgekühlten NVIDIA HGX H100- und H200-basierten SuperClustern führt. Darüber hinaus erweitert Supermicro das Portfolio seiner NVIDIA Hopper-Systeme.

„Supermicro verfügt über das Know-how, die Liefergeschwindigkeit und die Kapazität, um die weltweit größten flüssigkeitsgekühlten KI-Rechenzentrumsprojekte mit 100.000 GPUs zu realisieren, zu denen Supermicro und NVIDIA beigetragen haben und die kürzlich installiert wurden“, sagte Charles Liang, Präsident und CEO von Supermicro. „Die SuperCluster Lösungen von Supermicro reduzieren den Strombedarf mit Direct Liquid Cooling. Wir haben jetzt Lösungen, die die NVIDIA Blackwell Plattform nutzen. Mit unserem modularen Ansatz können wir schnell Server mit NVIDIA HGX B200 8-GPUs entwickeln, die entweder flüssigkeits- oder luftgekühlt sein können. Unsere SuperCluster Systeme bieten eine noch nie dagewesene Dichte, Leistung und Effizienz und ebnen den Weg für noch dichtere KI-Computing-Lösungen in der Zukunft. Die Supermicro Lösungen nutzen Direct Liquid Cooling, was zu höherer Leistung, geringerem StromverbrauchgeringeremStromverbrauch für das gesamte Rechenzentrum und geringeren Betriebskosten führt.“

Bewährte KI-Leistung in großem Maßstab: Supermicro NVIDIA HGX B200-Systeme

Die neue skalierbare SuperCluster-Einheit basiert auf einem Rack-Scale-Design mit innovativen vertikalen Kühlmittelverteilern (Coolant Distribution Manifold, CDM), die eine größere Anzahl von Compute-Nodes in einem einzigen Rack ermöglichen. Neu entwickelte und effiziente Kühlplatten und ein fortschrittliches Leitungsdesign verbessern die Effizienz des Flüssigkeitskühlsystems weiter. Eine neue Coolant Distribution Unit (CDU) für große Installationen ist ebenfalls verfügbar. Auch herkömmliche luftgekühlte Rechenzentren können von den Vorteilen der neuen NVIDIA HGX B200 8-GPU-Systeme mit einem neuen luftgekühlten Systemgehäuse profitieren.

Die neuen Supermicro NVIDIA HGX B200 8-GPU Systeme bieten eine Reihe von Verbesserungen gegenüber der Vorgängergeneration. Das neue System umfasst Verbesserungen bei der Wärmeabgabe und der Stromversorgung sowie Unterstützung für zwei 500W Intel Xeon 6 oder AMD EPYC 9005 Prozessoren. Das neue luftgekühlte 10HE NVIDIA HGX B200 System verfügt über ein neu gestaltetes Gehäuse mit erweitertem thermischem Spielraum für 8 Blackwell-GPUs mit 1000W TDP. Diese Systeme sind mit einem 1:1 Verhältnis von GPU zu NIC ausgelegt und unterstützen NVIDIA BlueField-3 SuperNICs oder NVIDIA ConnectX-7 NICs für die Skalierung bis hin zu einer Hochleistungs-Compute-Fabric. Darüber hinaus beschleunigen Diese Systeme sind mit einem 1:1 Verhältnis von GPU zu NIC ausgelegt und unterstützen NVIDIA BlueField®-3 SuperNICs oder NVIDIA ConnectX®-7 NICs für die Skalierung bis hin zu einer Hochleistungs-Rechenfabrik. Darüber hinaus rationalisieren zwei NVIDIA BlueField-3 Datenverarbeitungseinheiten (DPUs) pro System die Datenverarbeitung von und zu angeschlossenem Hochleistungs-KI-Speicher.

Supermicro Lösungen mit NVIDIA GB200 Grace Blackwell Superchips

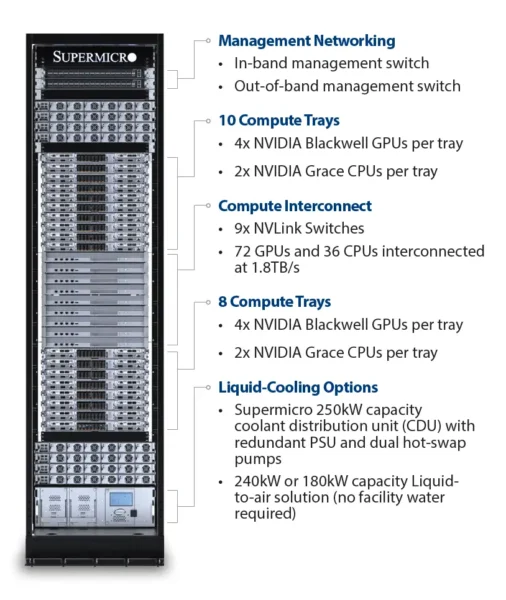

Supermicro bietet auch Lösungen für alle NVIDIA GB200 Grace Blackwell Superchips, einschließlich des neu angekündigten NVIDIA GB200 NVL4 Superchips und des NVIDIA GB200 NVL72 Single-Rack Exascale Computers.

Die Supermicro NVIDIA MGX Systeme unterstützen den NVIDIA GB200 Grace Blackwell NVL4 Superchip. Dieser Superchip erschließt die Zukunft von konvergentem HPC und KI und bietet revolutionäre Leistung durch vier NVIDIA NVLink-verbundene Blackwell-GPUs, die über NVLink-C2C mit zwei NVIDIA Grace-CPUs verbunden sind. Der Superchip ist mit den flüssigkeitsgekühlten modularen NVIDIA MGX-Systemen von Supermicro kompatibel und bietet im Vergleich zur vorherigen Generation eine bis zu 2-mal höhere Leistung für wissenschaftliche Berechnungen, das Training von Graph-Neural-Networks (GNN) und Inferenzanwendungen.

Der NVIDIA GB200 NVL72 SuperCluster mit einer durchgängigen Supermicro-Flüssigkühlungslösung bietet einen Exascale-Supercomputer in einem einzigen Rack mit der SuperCloud Composer (SCC)-Software für umfassende Überwachungs- und Verwaltungsfunktionen für flüssigkeitsgekühlte Rechenzentren. 72 NVIDIA Blackwell-Grafikprozessoren und 36 NVIDIA Grace-CPUs sind alle über NVIDIA NVLink und NVLink Switches der fünften Generation verbunden und arbeiten effektiv wie eine große leistungsstarke GPU mit einem riesigen Pool an HBM3e-Speicher, wodurch eine Interconnect-Bandbreite von 130 TB/s mit geringer Latenz ermöglicht wird.

Accelerated Computing Systeme mit NVIDIA H200 NVL

Die Supermicro 5HE PCIe Accelerated Computing Systeme sind jetzt mit NVIDIA H200 NVL erhältlich. Sie eignen sich für luftgekühlte Enterprise-Rack-Designs mit geringerem Stromverbrauch, die flexible Konfigurationen erfordern, und bieten eine Beschleunigung für viele KI- und HPC-Workloads unabhängig von der Größe. Mit bis zu vier über NVIDIA NVLink verbundenen Grafikprozessoren, einer 1,5-fachen Speicherkapazität und einer 1,2-fachen Bandbreitensteigerung durch HBM3e kann der NVIDIA H200 NVL LLMs in wenigen Stunden feinabstimmen und liefert eine bis zu 1,7-fach schnellere LLM-Inferenzleistung als die Vorgängergeneration. Der NVIDIA H200 NVL beinhaltet außerdem ein Fünf-Jahres-Abonnement für NVIDIA AI Enterprise, eine Cloud-native Software-Plattform für die Entwicklung und Bereitstellung von KI in der Produktion.

Die Supermicro X14 und H14 5HE-PCIe Accelerated Computing Systeme Rechnersysteme unterstützen bis zu zwei 4-Wege-NVIDIA-H200-NVL-Systeme über die NVLink-Technologie mit insgesamt 8 GPUs in einem System und bieten eine GPU-zu-GPU Verbindung mit bis zu 900 GB/s mit einem kombinierten Pool von 564 GB HBM3e-Speicher pro 4-GPU-NVLink-Domäne. Das neue PCIe Accelerated Computing System kann bis zu 10 PCIe-GPUs aufnehmen und ist jetzt auch mit den neuesten Intel Xeon 6 oder AMD EPYC 9005 Prozessoren ausgestattet, um flexible und vielseitige Optionen für HPC- und KI-Anwendungen zu bieten.

Neueste Kommentare

24. April 2025

24. April 2025

18. April 2025

15. April 2025

14. April 2025

14. April 2025